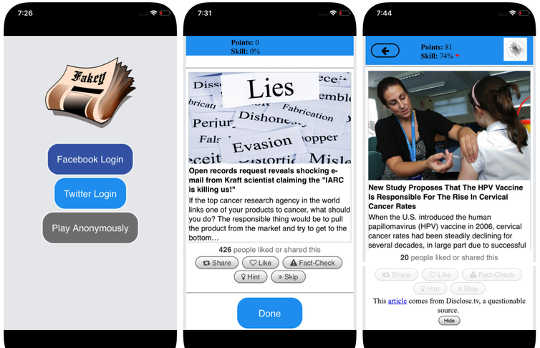

Fakey遊戲的屏幕截圖。 Mihai Avram和Filippo Menczer

Fakey遊戲的屏幕截圖。 Mihai Avram和Filippo Menczer

社交媒體是其中之一 美國的主要新聞來源 和世界各地。 然而,用戶接觸到可疑準確度的內容,包括 陰謀論, clickbait, 超黨派內容, 偽科學 乃至 捏造“假新聞”報導.

發布瞭如此多的虛假信息並不奇怪:垃圾郵件和在線欺詐 對犯罪分子來說是有利可圖的以及政府和政治宣傳的產量 黨派和經濟利益。 但事實是 低可信度內容傳播如此迅速和輕鬆 表明人們和社交媒體平台背後的算法容易受到操縱。

我們的研究發現了三種偏見,使社交媒體生態系統容易受到有意和無意的錯誤信息的影響。 這就是我們的原因 社交媒體觀察站 在印第安納大學正在建設 工具 幫助人們意識到這些偏見,並保護自己免受外部影響,以利用它們。

解釋社會媒體觀察站開發的工具:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

大腦中的偏見

認知偏差源於大腦處理每個人每天遇到的信息的方式。 大腦只能處理有限數量的信息,並且可能會導致過多的傳入刺激 信息過載。 這本身就對社交媒體上的信息質量產生了嚴重影響。 我們發現,用戶受到有限注意的激烈競爭意味著 儘管質量低劣,但有些想法仍然存在 - 即使人們喜歡分享高質量的內容.

為了避免不堪重負,大腦使用了 技巧數量。 這些方法通常是有效的,但也可能有效 成為偏見 在錯誤的環境中應用時。

當一個人決定是否分享他們的社交媒體提要上出現的故事時,會發生一個認知捷徑。 人們是 受標題的情感內涵影響很大,即使這不是文章準確性的良好指標。 更重要的是 是誰寫的.

為了克服這種偏見,並在分享之前幫助人們更多地關注索賠的來源,我們開發了 Fakey,一個移動新聞識字遊戲(免費上網 Android 和 iOS模擬一個典型的社交媒體新聞源,其中包含來自主流和低可信度來源的新聞文章。 玩家可以獲得更多積分,用於從可靠來源分享新聞並標記可疑內容以進行事實核查。 在這個過程中,他們學會識別來源可信度的信號,例如超黨派主張和情緒化的頭條新聞。

社會偏見

另一個偏見來源於社會。 當人們直接與同齡人聯繫時,指導他們選擇朋友的社交偏見會影響他們所看到的信息。

事實上,在我們的研究中,我們發現它是可能的 確定Twitter用戶的政治傾向 只需看看他們朋友的黨派偏好。 我們對這些結構的分析 黨派通訊網絡 發現社交網絡在傳播信息方面特別有效 - 準確與否 - 何時 他們緊密聯繫在一起,與社會其他部分脫節.

如果信息來自他們自己的社交圈內,則更有利於評估信息的傾向創造了“迴聲室“無論是有意還是無意地操縱,都是成熟的。 這有助於解釋為什麼這麼多在線對話轉變為什麼 “我們與他們”的對抗.

為了研究在線社交網絡的結構如何使用戶容易受到虛假信息的影響,我們建立了 Hoaxy,一個跟踪和可視化來自低可信度來源的內容傳播的系統,以及它如何與事實檢查內容競爭。 我們對XaUMX美國總統選舉期間Hoaxy收集的數據進行的分析表明,Twitter賬戶中存在錯誤信息。 幾乎完全切斷了 來自事實檢查員的更正。

當我們深入研究錯誤信息傳播賬戶時,我們發現一個非常密集的核心賬戶組幾乎完全相互轉發 - 包括幾個機器人。 事實檢查組織在被誤導的群體中被用戶引用或提及的唯一一次是質疑他們的合法性或者聲稱與他們寫的內容相反。

在機器中的偏見

第三組偏見直接來自用於確定人們在網上看到的內容的算法。 社交媒體平台和搜索引擎都使用它們。 這些個性化技術旨在為每個用戶選擇最具吸引力和相關性的內容。 但在這樣做的過程中,最終可能會加劇用戶的認知和社交偏見,從而使他們更容易受到操縱。

例如,詳細 廣告工具內置於許多社交媒體平台 讓虛假信息活動家利用 確認偏誤 by 定制消息 那些已經傾向於相信他們的人。

此外,如果用戶經常點擊特定新聞來源的Facebook鏈接,Facebook會 傾向於向該人展示該網站的更多內容。 這個所謂的“過濾氣泡“效應可能會使人們從不同的角度出發,加強確認偏見。

我們自己的研究表明,與維基百科等非社交媒體網站相比,社交媒體平台將用戶暴露給不太多樣化的資源。 因為這是整個平台的水平,而不是單個用戶,我們稱之為 同質性偏見.

社交媒體的另一個重要組成部分是根據獲得最多點擊次數的信息在平台上呈現趨勢。 我們稱之為 人氣偏見,因為我們發現用於推廣熱門內容的算法可能會對平台上的信息整體質量產生負面影響。 這也助長了現有的認知偏見,加強了看似受歡迎的東西,無論其質量如何。

所有這些算法偏差都可以被操縱 社交機器人,通過社交媒體賬戶與人交互的計算機程序。 大多數社交機器人,比如Twitter 大本鐘(Big Ben),是無害的。 然而,有些人隱瞞了他們的真實性質,並被用於惡意意圖,例如 助長虛假信息 或者是錯誤的 創造了草根運動的外觀,也被稱為“astroturfing。”我們發現 這種操縱的證據 在2010美國中期選舉前夕。

為了研究這些操縱策略,我們開發了一種檢測社交機器人的工具 Botometer。 Botometer使用機器學習來檢測機器人帳戶,檢查Twitter帳戶的數千種不同功能,例如帖子的時間,推文的頻率,以及它跟隨和轉發的帳戶。 它並不完美,但它揭示了盡可能多的 15百分比的Twitter帳戶顯示出機器人的跡象.

將Botometer與Hoaxy結合使用,我們在2016美國總統競選期間分析了錯誤信息網絡的核心。 我們發現很多機器人利用受害者的認知,確認和受歡迎程度以及Twitter的算法偏見。

這些機器人能夠在易受攻擊的用戶周圍構建過濾泡沫,為他們提供虛假聲明和錯誤信息。 首先,它們可以通過發送候選人的主題標籤或者通過提及和轉發該人來吸引支持特定候選人的人類用戶的注意力。 然後機器人可以通過轉發與某些關鍵字匹配的低可信度來源的文章來放大虛假宣稱塗抹對手。 此活動還使該算法突出顯示其他用戶廣泛共享的虛假故事。

了解複雜的漏洞

即使我們的研究和其他人的研究表明個人,機構甚至整個社會如何在社交媒體上被操縱,也有 許多問題 離開回答。 發現這些不同的偏見如何相互作用尤其重要,可能會產生更複雜的漏洞。

像我們這樣的工具為互聯網用戶提供了有關虛假信息的更多信息,因此可以對其造成一定程度的保護。 解決方案將 不太可能只是技術雖然他們可能會有一些技術方面的問題。 但他們必須考慮到 認知和社會方面 這個問題。

關於作者

Giovanni Luca Ciampaglia,印第安納大學網絡科學研究所助理研究科學家, 美國印第安納大學 和Filippo Menczer,計算機科學和信息學教授; 複雜網絡與系統研究中心主任, 美國印第安納大學

相關書籍

at

感謝造訪 InnerSelf.com, 哪裡有 20,000+ 宣傳“新態度和新可能性”的改變生活的文章。 所有文章均翻譯為 超過30種語言. 訂閱 每週出版的《內在自我》雜誌和瑪麗·T·拉塞爾的《每日靈感》。 InnerSelf雜誌 自 1985 年起出版。

感謝造訪 InnerSelf.com, 哪裡有 20,000+ 宣傳“新態度和新可能性”的改變生活的文章。 所有文章均翻譯為 超過30種語言. 訂閱 每週出版的《內在自我》雜誌和瑪麗·T·拉塞爾的《每日靈感》。 InnerSelf雜誌 自 1985 年起出版。